Hallo, seit paar Wochen wurden fast alle meine Seiten aus den Google Index genommen mit dem vermerk:

"Duplikat – vom Nutzer nicht als kanonisch festgelegt"

Vor einem Monat waren noch alle Indexiert.

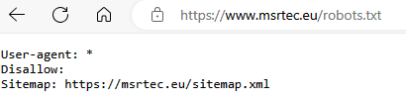

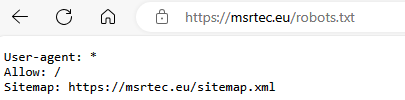

Ich habe 3 Domains .de .com .eu wobei jeweils 2 mit einer 301 Weiterleitung auf meine Haupt Domain weiterleiten.

Auch habe ich eine Subdomain eingerichtet die von www. auf meine Haupt Domain weiterleitet.

Könnte das das Problem sein, oder wo sollte man anfangen?

"Duplikat – vom Nutzer nicht als kanonisch festgelegt"

Vor einem Monat waren noch alle Indexiert.

Ich habe 3 Domains .de .com .eu wobei jeweils 2 mit einer 301 Weiterleitung auf meine Haupt Domain weiterleiten.

Auch habe ich eine Subdomain eingerichtet die von www. auf meine Haupt Domain weiterleitet.

Könnte das das Problem sein, oder wo sollte man anfangen?